2023年1月6日,由稀土掘金技术社区与 Intel 联合发起的第一届「掘金未来大会」在北京成功举行。

大会上,Intel Habana 中国区业务总监于明扬带来了Intel 助力 AI 大模型浪潮下,如何帮助企业进行数字化创新和变革。他提到,AI 大模型是最具想象力的科技发展方向之一,模型不止于“大”,通用、开放、高效、善良,是 AI 大模型的理想标准。目前,大模型生态已经达到了一个比较完善的地步,可以方便很多的开发者去进行研究和分析,甚至开始进行部署。但随着模型参数与数据集规模不断增大,无形中带来了许多问题和挑战,其中,开源是大模型未来发展中的一个非常重要的手段。

于明扬预测,大模型是 AI 领域里一个新的科技创新,AI 大模型有可能带来下一轮人工智能的发展浪潮。合作、开源将会给大模型的发展带来更大的动力。随着大模型的发展,在数据安全、伦理道德、模型易用性以及模型友好程度等各个方面,通过大家的探讨能够去更加完善,保证大模型在未来的使用当中能够真正地帮助和解决实际问题,而不会去造成更多的困扰。

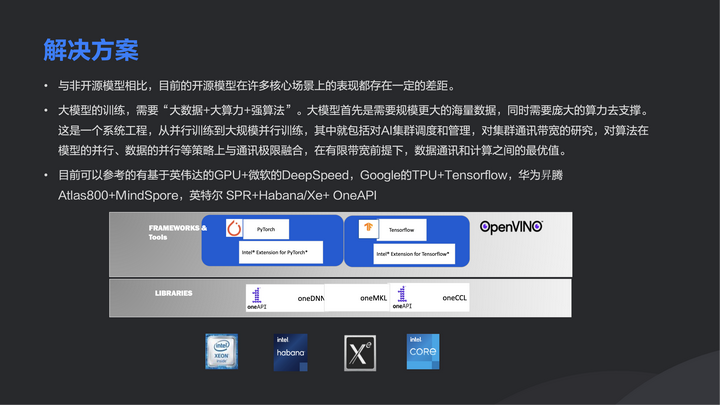

大模型的训练,需要“大数据+大算力+强算法”,英特尔基于这三个方面提出相关的解决方案,来帮助客户去克服目前大模型部署和使用中的问题。目前英特尔SPR+Habana/Xe+OpenAPI的完整平台已经在一些行业中得到验证,利用并行异构系统解决数据获取、处理、计算和存储,实现大模型的高效训练与推理。

以下为Intel Habana 中国区业务总监于明扬演讲全文:

今天我给大家带来是,Intel 助力 AI 大模型浪潮下,如何帮助企业进行数字化创新和变革。

大家都了解,英特尔主要的产品是基础的计算平台,同时英特尔也向很多客户提供各种各样的软件的中间解决方案。在未来一段时间里,尤其是在人工智能的发展阶段中,越来越多的大模型应用场景出现。在大模型这一新业态下如何建立完整的生态环境,这是很多企业必须要考虑事情。在此情况下,我们带来了一些新的想法,借助这个机会跟大家交流,倾听大家的一些意见,不断去地改进整个生态。

今天的介绍主要围绕几个方面:

简单回顾一下大模型的发展历史,以及目前大模型在整个行业中的使用情况;

针对大模型在很多行业中普遍出现的一些问题,英特尔尝试提供的一些解决方案,供大家参考;

从英特尔的角度,对大模型未来的发展评估和分析。

大模型生态已经初具规模

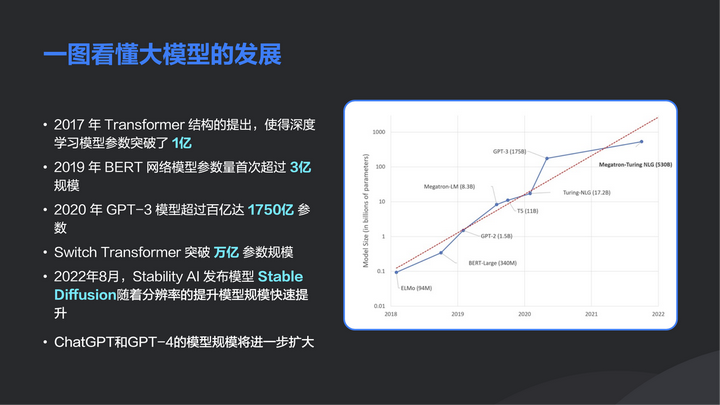

2017 年, Transformer 结构的提出,使深度学习模型参数达到了上亿的规模。到了 2019 年,Google 率先发布了第一个大规模的语言模型 Bert,其参数首次超过 3 亿规模。但很快在 2020 年,OpenAI 推出了更大规模的语言训练模型 GPT-3,其参数达到了 1750 亿。仅一年时间,整个模型的规模就从亿级突破到了上千亿。但这种高速的发展并没有结束,在今年又出现了一些新的常规业态大模型,比如 Stability AI,它发布的文字到图像的创新模型 Diffusion 。去年年底刚刚出现了 ChatGPT, 以及 OpenAI 今年即将发布的GPT-4,预期它们带来的模型参数会有更快速的增长。

大模型的参数和数据规模的增长,会带来什么样的变化?首先,大模型集成了各种不同模态下的数据,从传统的有限的 AI 扩展到更多的应用场景;其次,大模型通过预训练以及针对下游业务进行的预调整,可以适用于各种各样的细分应用场景。它可以把各种结构化数据和非结构化数据结合起来,帮助更多的行业完成人工智能部署的要求;随着大模型的参数和数据量不断增加,大模型的整体训练精度也得到了不断地提高。现在的自然语言处理的精度已经非常接近于人的处理水平,这也是大模型带来的巨大变化。

另外,大模型通过一些自监督的学习方法,很大程度上解决了传统人工智能中对于数据标注的高成本、长周期和精确度的问题。大模型的业务发展越来越快。过去,大模型主要针对语言模型的发展;现在,大模型已经突破了传统的自然语言处理,发展到对图像的处理,以及一些自动模式识别等等,所以大模型的业务场景已经突破了传统且最早的定义限制。

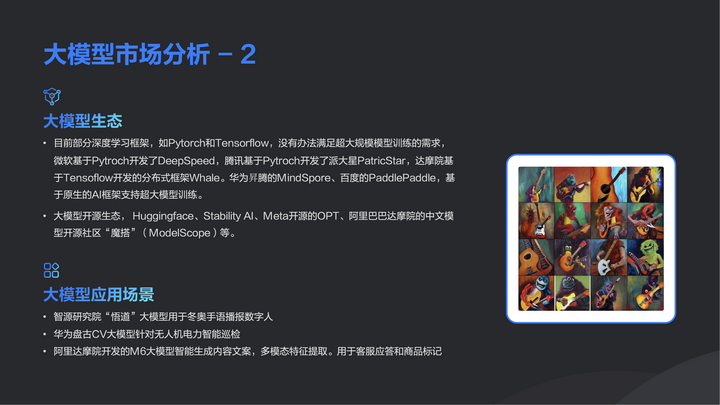

再看大模型生态。大模型生态是比较完善的,虽然一些传统的人工智能训练框架,比如 Pytorch 和 Tensorflow,对于运行一些大模型的训练还是有局限性,但是在行业内,越来越多的厂家已经参与到大模型框架的开发中,比如,微软基于 Pytorch 开发了 DeepSpeed,以及国内的一些厂家,百度、阿里、华为等等,都推出了一些针对大模型的改良框架,很好地支持了目前很多通用的大模型训练。因此,大模型生态已经初具规模。

其次,从大模型开源生态讲,已经有很多厂家提供了大模型开源环境,比如,Huggingface、Stability AI、Meta 开源的的OPT等,他们都提供了深度开源的代码,供大家进行二次开发。所以大模型生态已经达到了一个比较完善的地步,可以方便很多的开发者去进行研究和分析,甚至开始进行部署。

模型参数与数据集规模不断增大

在整个大模型的发展中,很多大模型的业务已经开始落地,比如,智源实验室推出“悟道”大模型已经用于冬奥会上手语播报数字人;华为采用盘古CV大模型平台,在无人机电力巡检中获得了一些实际效果。

大模型看似发展已经很好了,为什么我们在生活中对大模型的感受并不是很强烈?对比最早的人工智能的应用,我们会感觉到大模型好像离我们很远,这并不是说大模型不适合日常应用场景,而是大模型的使用有一定的门槛,这种门槛造成了大模型在很多应用场景下的部署以及使用的瓶颈。

首先,大模型的数据量很大,其次它的整个模型参数也是一个非常高的数量级,并且随着大模型的演变和发展,参数规模与数据集规模不断地呈指数级增加。

举一个例子,GPT-3 最大的模型参数量达到了 1750 亿,训练数据超过了 45TB,如果要完成一次 GPT-3 完整的训练过程,大约需要 3.14E FLOPS 的算力。这意味着什么?全世界最高效的 HPC 集群的理论计算峰值才刚刚达到这个数字,我们不可能建立如此大的集群来训练一个模型,这无形之中造成了大模型发展的最大瓶颈,就是如何解决训练中的算力要求。除此之外,大模型还对平台的部署提出了很多新的要求,比如,在分布式并行的场景下,如何提高整个系统的使用效率?如何解决在大模型中很多核心算法的利用率问题?这些问题对于很多中小企业和普通开发者造成了很大障碍。

大模型在行业中之所以很难广泛应用,是因为它的算力,以及对整个开发环境的要求,使整个生态还是有一定的困难和门槛。如何解决这个问题,就是 Intel 一直在尝试和努力探索的方向。Intel 已经与行业内很多合作伙伴去建立了开源合作基础。开源是大模型未来发展中的一个非常重要的手段。

首先,开源可以集中各个方面的能力和资源解决模型当中的优化问题,同时,利用开源可以把很多计算资源集中起来完成对大模型的训练。另外,开源还可以解决很多大模型未来部署实施中的一些顾虑,提出解决方法。因此,开源是解决大模型未来发展的一个最重要的手段。其次,一些企业开始尝试把一些大模型拆分成针对于特殊应用场景的小规模训练集,保证一些模型在特定场景下也可以部署和使用,这是一种解决方案。同时,各地政府和一些研究机构也在部署自己的算力集群,通过社会层面去解决算力需求的问题。

还有一个趋势是加速大模型的使用。对于模型的训练来说并不见得是有非常强的要求,很多普通用户更多的是希望在业务中去部署大模型,这种大模型的部署需要推理的能力。如何解决高效、低成本、环保的推理解决方案,这也是大模型部署当中需要考虑的一个问题。现在,Intel 已经和第三方厂家去共同努力给客户提供一个更好的调优以及进行二次开发的环境,帮助很多客户解决他们在未来大模型使用和部署当中遇到的一些问题。

大模型中最核心的三个点:大数据、大算力、强算法

和开源的大模型相比,现在很多非开源模型还是有整体优势的。在整体训练的精确度上,它和开源相比还是有一定的优势,它的一些场景要领先于开源。大模型中最核心的三个点:大数据:大算力、强算法。根据这三个点,Intel 提出了解决方案,帮助客户解决大模型部署和使用中所出现的一些问题。

在大数据方面,需要更多的行业参与者去提供各种数据格式的数据资源,把这些数据整合到一起就有可能去做一个数据层面的突破。在算力方面,Intel 为客户提供高效的算力解决方案。 Intel 也提供一个开源的、友善的以及非常灵活的大数据的框架,就是 基于Intel 的 Sapphire Rapids 新一代的至强处理器,Intel Habana 高性价比AI 加速设备、 Intel 最新的 GPU 的 Xe 处理设备,以及我们在一直在行业内大力推广的 oneAPI 的开源框架。

Intel 通过这样一个完整的平台去帮助客户解决大模型训练、推理以及部署当中的问题,并且已经在一些行业中获得了验证。图中是Intel 在全球多个地点和客户共同配合去提供的一个完整的大模型训练和推理部署的解决方案。在这个方案中,可以满足客户数据获取、数据预处理,以及在整个模型训练和推理中对计算和存储的要求。目前,国内一些地方已经开始部署这个平台,未来 Intel 还会把平台上的算力资源、集成的 Intel 软件,以及 Intel 和合作伙伴共同开发的一些应用提供给大家进行试用。

在Habana平台中, Intel 选择了微软的 DeepSpeed,之所以选择 DeepSpeed 这一非开源平台,是因为非开源的大规模框架平台有一定的优势,一方面,它在计算精度上比开源模型有更高的标准,另一方面,它在整个生态中提供了比较好的 API 的接口,便于客户进行更多的二次开发和研究。

Intel 最核心考虑的一点就是内存的利用率。在大模型使用过程中,内存资源的占用是非常耗费平台整体资源,比如,在训练过程中,很多参数的内容需要保存在 AI 训练加速设备当中,这种资源的占用带来两个的因素,第一是随着占用设备内存的增加,计算规模肯定要扩大;第二是数据内容要不断地进行反复加载、反复集中,这样对整个集群的通讯效率造成很大的压力。

因此,Intel 尝试去做一些简单的优化和处理。Intel 选择 DeepSpeed 提供的一个零冗余的内存优化方案解决在内存分配中所遇到的一些资源上的浪费,通过高效网络带宽解决并行处理的参数分发以及参数集中。现有的网络通讯包含两个方案:一种是交换式解决方案,如英伟达 NVLink 集群化的解决方案;一种是点到点全连通的解决方案。不是说这两种解决方案哪一种更优,Intel 也在不断地尝试不同的通讯协议对于大模型的训练带来的价值。

另外,考虑到在模型的训练过程当中,模型状态的保存带来的资源消耗。Intel 利用了 DeepSpeed 里边的 ZeRO-1、 ZeRO-2,甚至 ZeRO-3 整个的模型参数的分发原则,通过不同的模型参数资源的分配可以把整个模型对于内存资源的占用呈指数级的下降,通过最高级别的内存优化可以做到内存的资源耗费大约只占原来标准模型的 1/ 16。这对于一个大规模的模型部署来讲,是一个非常有价值的尝试,而且这种尝试可以看到它的效率、性价比还是非常有优势的。另外,如何去利用不同精度的混合计算去解决计算的资源,以及最后计算结果的精度的问题,这也是一个非常有意思的尝试。

目前,在很多的加速设备中,大家都能支持 BF 16,也能支持 FP 32。在 BF16 的使用场景中,很大程度上节省资源的占用的问题,但无形当中会带来一些很大的准确性隐患。在反向计算中可能会丧失一些信息,会引入一些误差,降低整个模型最后训练的精度,那么结合 FP32 就可以很好的解决这个问题。Intel 选择了一个比较灵活的模式,对整个架构做了一些探索,这种探索是有一定的收获,也愿意把这些经验分享给大家。在 Intel Habana网站上,就有非常详细的技术实现方案,包括技术的原理以及整个参考代码,大家可以体验一下优化所带来的效果。

AI 大模型有可能带动新一轮的人工智能发展浪潮

从 Intel 角度来讲,对于未来大模型是持一个什么样的看法?首先,在最近一段时间内,大模型是 AI 领域里一个新的科技创新,AI 大模型有可能带来下一轮人工智能发展浪潮。这几年人工智能的发展已经达到了一个巅峰,尤其是在图像识别领域,它基本上超过人的识别能力,但在自然语言的处理方面,机器学习、深度学习一直落后于人的处理能力,所以大模型的出现弥补了这个方面不足。

其次,大模型的应用场景。传统的 AI 模型都是碎片化、专业化的场景,往往针对视频监控、人脸识别以及一些特定的场景,但大模型的使用会把应用场景扩展到更大,不仅是 AIGC 这种内容生成,还会对很多细分领域带来新的创新。所以未来大模型有可能会成为人工智能里一个比较集成化的解决方案,对于很多的用户来说,未来的使用大模型可能会带来更多的灵活性和易用性。

再者,合作、开源将会给大模型的发展带来更大的动力。开源是未来大模型发展当中的一个重要的环节,在开源中如何帮助大模型去完善解决开源和非开源大模型中的精度误差,也是要探讨的一个问题。

系统厂家也不断通过硬件性能的提升和架构优化解决大模型训练和推理的效率。无论是硬件厂家,还是框架和平台厂家,在这几年在大模型的调优上都花费了很大的精力,虽然大模型的数据和算力要求在不断的增长,但是像Intel 这样的硬件厂家也不断地在硬件设备上提供能力的补充,尽管跟模型的需求有一定的差异,但是这种差异相信在未来会不断地缩小。

随着大模型的发展,在数据安全、伦理道德、模型易用性以及模型友好程度等各个方面,通过大家的探讨去进一步完善,保证大模型在未来的使用当中能够真正地解决大家的实际问题,而不会去造成更多的困扰。

同时,国内的很多研究机构花费了很大的精力建立了自己的专有训练集群,他们去开发自己的大模型,但在落地和应用中还是有一定的欠缺。希望有更多的厂家企业参与到未来大模型的生态环境当中,提供更多的应用场景,帮助机构把大模型落实到实际业务中,去解决社会面临的实际问题。谢谢大家!

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

文章投诉热线:156 0057 2229 投诉邮箱:29132 36@qq.com