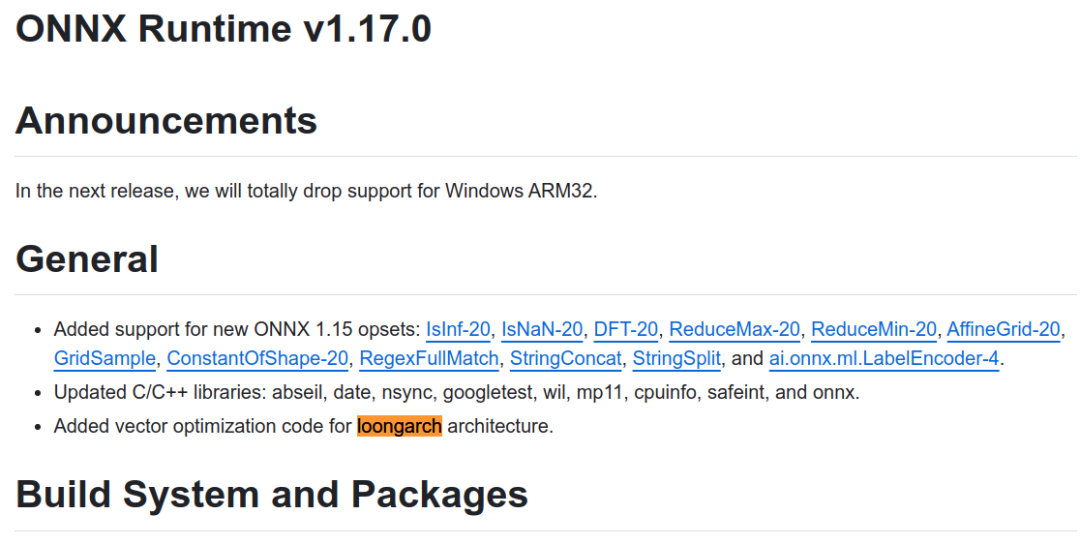

近日,知名AI推理框架开源社区ONNX Runtime正式发布支持龙架构的版本1.17.0。今后,用户可以直接使用ONNX Runtime开源社区发布的版本在龙芯平台完成AI推理类应用的开发和部署,标志着龙架构软件生态得到进一步完善。

ONNX Runtime(ORT)是近年来兴起的AI推理框架软件,被大量AI应用作为基础AI推理引擎。ORT可支持PyTorch、Tensorflow、TFLite等多种格式的模型输入,以及CPU、GPU、IoT、NPU、FPGA等多样化算力后端。

在ONNX Runtime 社区1.17.0版本的研制过程中,龙芯中科技术团队与社区保持紧密合作,期间向ONNX Runtime社区代码仓库提交了7697行代码,对矩阵乘法、卷积、转置等核心算子进行深度向量优化。在社区支持下,龙架构优化代码通过了检视、测试验证等质量保证流程,ONNX Runtime社区自1.17.0版本起正式实现对龙架构的原生支持。

未来,龙芯中科将继续与AI领域的国际开源软件社区携手合作,助力AI领域的生态发展和技术创新,为用户带来更优产品,实现更大价值。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

文章投诉热线:182 3641 3660 投诉邮箱:7983347 16@qq.com