造一台车简单,还是开一台车简单?

很多人都会回答:开车。但答案可能是反直觉的。

先来看造车,尽管造一辆车需要成千上万人投入其中,但其实际遵循的是非常成熟的工艺流程。

开车看起来很容易学会,驾考培训也早已成为一套流程化产业,但合格的司机不仅会按照规则开车,更能够非常灵活的处理各种极端场景。

实际上,造车虽然看起来复杂,但其实际是一个“简单系统”。开车虽然看起来很容易,但其实际是一个“复杂系统”。

既能够有预判,又能够有灵活的博弈,人类对于自己开车时的每一次判断和决策,都能给出合理的解释,这是造车的规则式逻辑无法做到的。

这也是为什么自动驾驶实现起来如此艰难的原因。

现在,人们希望借助人工智能,赋予机械模仿、超越人类驾驶的能力,但想要让自动驾驶像人类驾驶依旧很难。

困难之处就在于,人类驾驶作为一套复杂系统,既有充分的灵活性,又有可解释性。但人工智能正在逐步攻克感知识别的自主性和认知决策的灵活性难题,但是又不可避免地陷入了深度网络的不可解释性难题。

具体来看,为了让自动驾驶能像人类驾驶一样具备充分的灵活性,自动驾驶正在通过深度学习算法来替代人工手写规则,如此虽然能让自动驾驶算法越来越聪明,但也带来了另一个问题,就是深度神经网络缺乏可解释性。

这就是我们常常提到的,在从感知硬件输入数据到算法模型输出决策之间,存在一个“黑箱”,我们无法从中得知算法运行的准确策略和逻辑,从而难以避免车辆做出一些匪夷所思的决策,比如说幽灵刹车,比如说蛇形走位。

关于可解释性,我们可以看看电影《复仇者联盟》中的反派——奥创。奥创这个人工智能自始至终的目的都是为了“维护世界和平”,这个可以看作是他的输出决策,但他实现这一目的的方式,却是毁灭全人类。

在这里,因为奥创能够兼容人类思维,并且长了一张能说会道的嘴,所以我们可以听他是如何解释“要想维护世界和平,就要毁灭全人类”的推理的。不过,这也只是编剧帮我们打开了奥创的“黑箱”。

但回到现实,如今的人工智能可没法像奥创一样自我解释,算法工程师也不能像电影编剧那么轻松打开人工智能的“黑箱”,我们不明白人工智能为什么会这么做,人工智能也没法向我们解释它为什么要这么做。

回到自动驾驶领域,这可能会带来算法歧视、算法安全和算法责任等方面的相关问题,这要求我们必须深入了解算法的可解释性问题。深度神经网络为什么会存在“黑箱”?我们又该如何破解“黑箱”?

“黑箱”难题,隐藏在自动驾驶的冰山之下

如果把自动驾驶比作一座冰山,那么“自动驾驶能不能跑起来”就是浮于海平面以上的那一角,这恰好是我们目前最关注的;而由算法可解释性带来的“黑箱”难题,则是海平面以下、我们尚未关注到的冰山的全部。

具体来看,当下的自动驾驶技术非常依赖深度神经网络,虽然这大幅优化了以往自动驾驶在面对泛化感知方面可能面临的各种问题,但因为缺乏归纳偏置,深度神经网络对未知情况的预测,既不能很好的确定,又不能给到很好的解释,这导致基于深度神经网络算法的自动驾驶缺乏可解释性。

换句话说,人类虽然学会了使用深度神经网络,但并没有完全理解深度神经网络。基于深度神经网络而来的算法模型虽然能让自动驾驶跑起来,但在很多时候用的却是“大炮轰蚊子”的办法,至于为什么不直接用手拍死蚊子,自动驾驶给不了我们答案。

举一个例子,特斯拉FSD几乎是建立在深度神经网络的基础上的,此前其在美国发生过几例关注度非常高的事故,比如没有识别出特种车辆、事故车辆,导致追尾发生。

这一情况不会是特斯拉的特例,因为它只是走得比其它自动驾驶企业更快而已,如果不从根源上避免,其它自动驾驶企业步特斯拉后尘只是时间问题。

从事后的分析来看,导致这类事故的原因,是自动驾驶与人类驾驶在识别物体的逻辑上有所不同。

面对一台涂装了广告或者是一辆侧翻的汽车,人类可以通过识别其体积、轮廓、局部特征等多种因素综合判断出这是一台车,但自动驾驶却可能优先识别出车身的物体,或者完全识别成其他物体。这种还是属于汽车感知能力不足的原因,我们还能理解。但是自动驾驶车辆很可能会因为一些光线、阴影等因素,会识别出完全超出人类可理解的范围。

自动驾驶是如何判断一个物体是不是汽车的?按照以往深度学习的逻辑,算法工程师会给到深度神经网络各种汽车的图像,而后者则会从这些图像中观察并总结汽车的特征,由此实现“认识”汽车。

和人类认识汽车的逻辑不同,深度神经网络没有办法问我们“为什么”,其对汽车的认识也只能被限制在图像中汽车的种类、角度与状态里,而如此总结出的汽车特征自然是不具备泛化性的。

发现这其中的问题了吗?如果自动驾驶车辆遇到了一台纯白的的汽车,即使人类能够一眼看出那是一台汽车,但在自动驾驶眼中,那大概率就是天空和白云,那么其决策结果,就很有可能会是直接开过去。

总的来看,人工智能在深度学习领域,只做到了通过概率模型来获得隐性知识,其在特定的、狭窄定义的任务中确实比人类高效,但一旦遇到类似烧到只剩骨架的车、翻倒的车、造型独特的车,甚至那些超过人类理解的场景等可能搞乱人工智能的数据被称为“对抗性数据”时,深度神经网络就可能失效。而对于自动驾驶来说,一次生效可能就意味着一次事故的发生。

此外,自动驾驶也可能会因感知失效而导致崩溃,但这些都要求自动驾驶的各个部分具备可解释性,这样我们才能准确得知崩溃原因,而不是用“事后诸葛亮”的方式去猜。

如果,深度神经网络的“黑箱”属性难以克服,算法的“可解释性”难题长久存在,那么自动驾驶将永远难以触达其所标榜地远超人类的安全性。那么由此,自动驾驶也会走向自己的反面。

但人类这个因果性物种,不会允许这样的问题存在。

赋予数据、算法模型可解释性,让“黑箱”变透明

自动驾驶的算法“黑箱”将影响到产品的安全性、舒适性与高效性体验,但对于历经百年的汽车产业而言,这些问题都会通过冗余系统进行预设并解决。

正常逻辑下,自动驾驶算法工程师会在自动驾驶技术上线前,通过不断挖掘算法漏洞,预知可能发生的问题并解决,最大限度增大系统的安全性冗余。

这一套方法的具体落地方式,就是依靠仿真系统。众所周知,训练成本是自动驾驶的大头,所以特斯拉、毫末智行等自动驾驶企业建立了一套仿真世界,可以在这里模拟各种复杂场景与变量,对算法模型进行训练。

虽然仿真系统极大提升了训练效率,但它并没有打开自动驾驶算法的“黑箱”,反倒更像是一套穷举法,指望深度神经网络与大算力平台消化海量数据降低corner case,或许简单粗暴,但并不治本。

解开自动驾驶算法“黑箱”的关键,是要赋予其从始至终的可解释性,这一点应当尝试从算法模型建模前、建模中与建模后三个阶段插手。

在建模之前,我们可以让数据可视化,这能让我们迅速而全面地了解数据分布的特征,从而帮助我们考虑在建模过程中可能面临的问题。

在建模之中,我们需要建立一套具备可解释性的算法模型,其可以是基于规则的,也可以是基于特征的,这样的目的在于降低归纳偏置,让决策能像用徒手拍蚊子一样简单直观,而不是用大炮轰蚊子。

在建模之后,我们可以用可解释的方法对算法模型进行解释,虽然算法模型中存在“黑箱”,但主要来源于其高度非线性特征,我们无法像理解线性函数那样,通过统计学基础假设来理解神经网络中以非线性函数获得的参数。

直观点说,我们实际是知道这些参数的具体值以及整个训练过程的,只是目前还没有办法用人类可以理解的方式理解模型的具体含义和行为。但我们可以利用深度神经网络神经元的分层组合形式,用物质组成的视角来理解神经网络的运作方式。

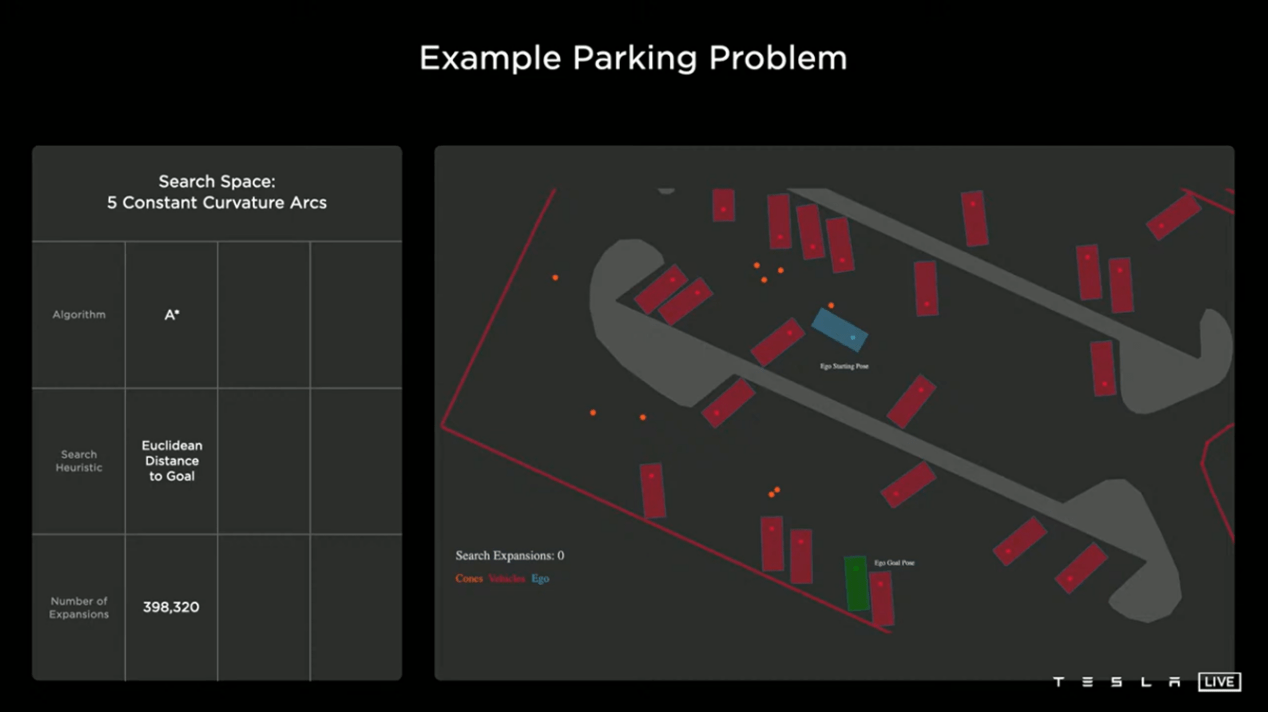

特斯拉虽然没有明确提出算法可解释性的提升,不过其决策逻辑是通过蒙特卡洛树搜索算法,在决策前根据当前状态,借助标注数据在深度神经网络中,以每秒166万次的频率快速模拟各种可能的解决方案,从中筛选出一个最适合的,在决策改变当前状态的同时,再进行重新模拟。

考虑到马斯克对第一性原理的信奉,我们可以这样理解特斯拉的决策逻辑:如果能把自动驾驶的决策逻辑培养得与人类驾驶几乎一致,那就相当于达到了人类可理解的水平。

这样的逻辑策略是否可行,其实还有待观察,但仅从当前特斯拉自动驾驶的发展状况来看,距离特斯拉“人车合一”的理想状态似乎还有些距离。

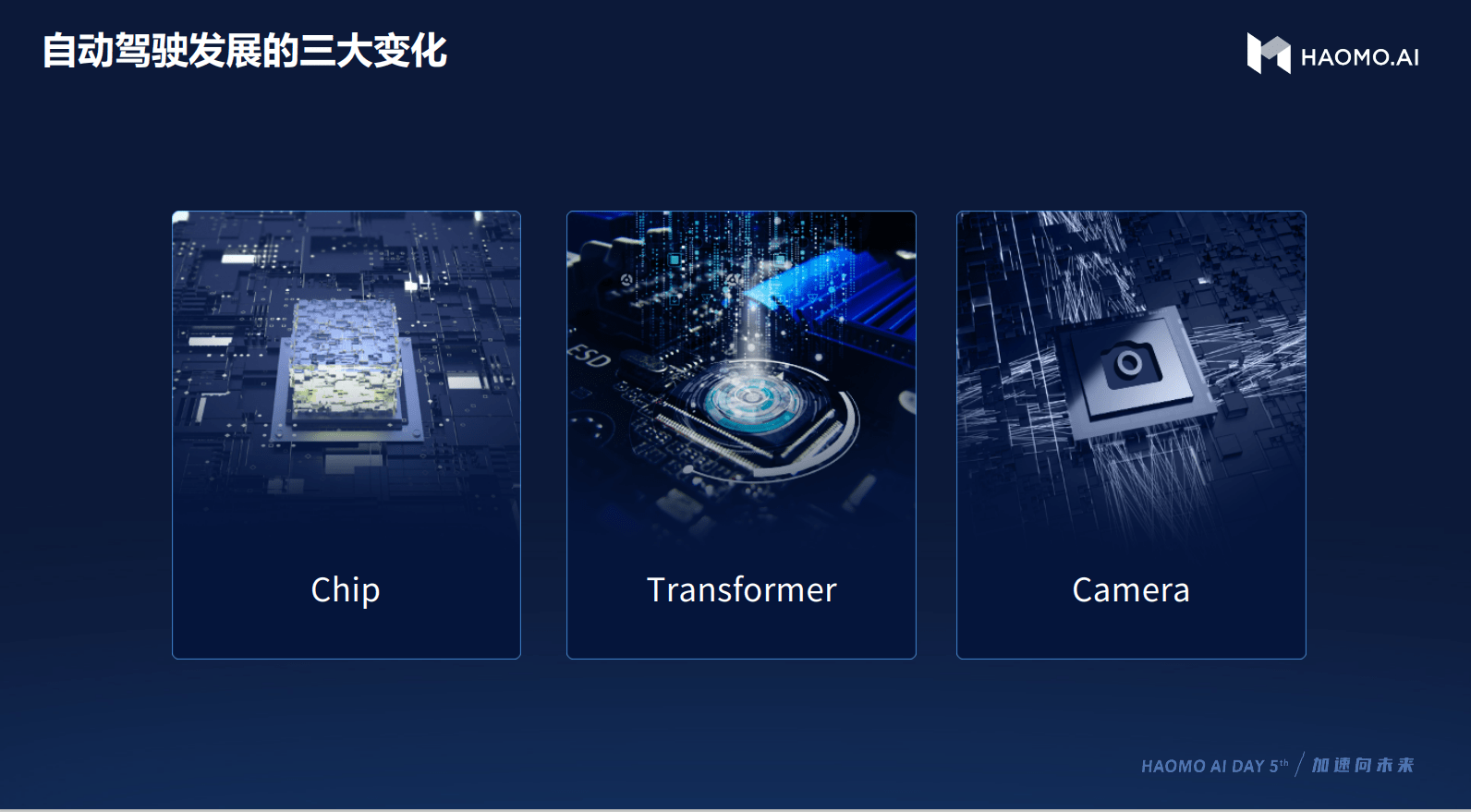

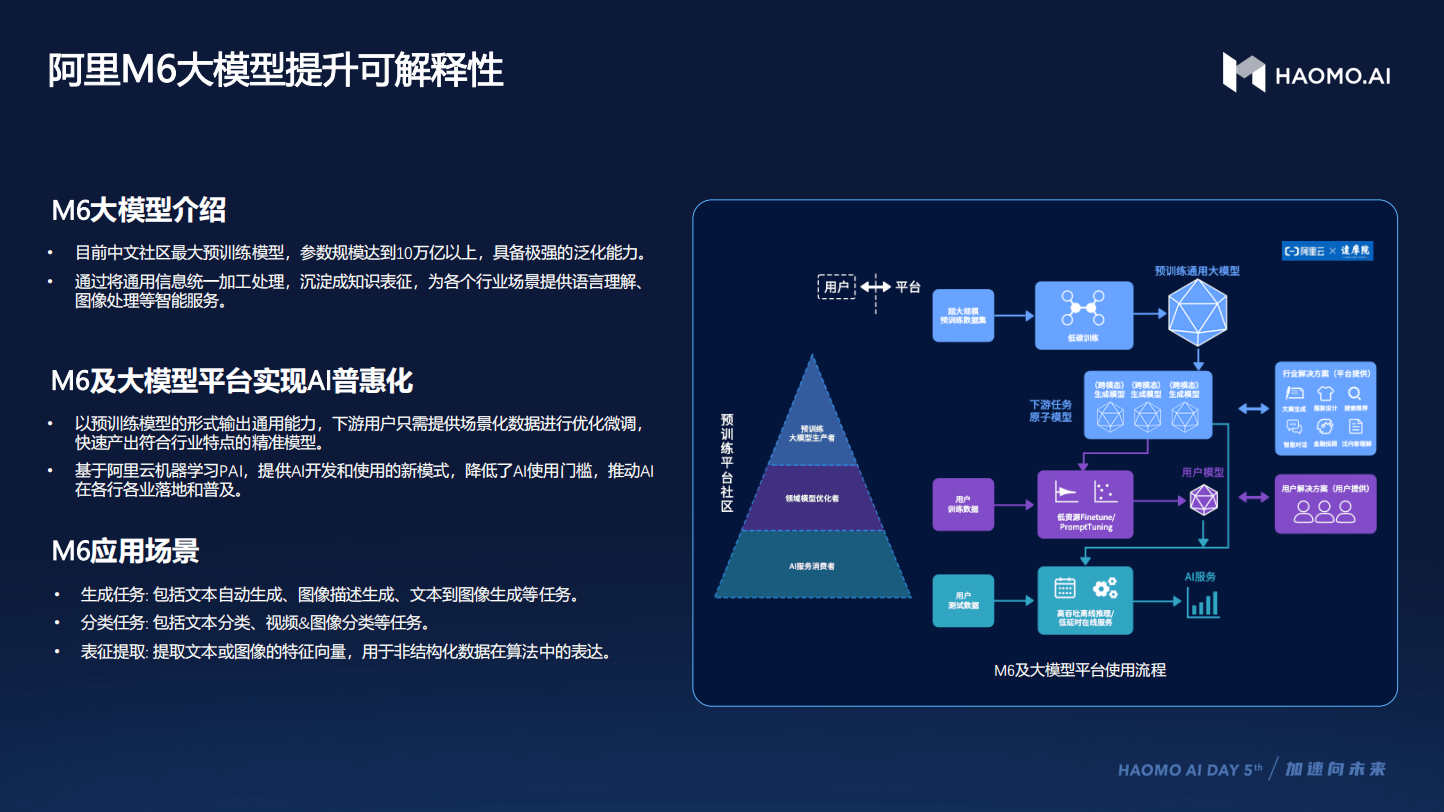

对比之下,毫末智行的决策策略中,对可解释性的处理相对细致一些。为了让自动驾驶算法做出更像人类驾驶的决策,毫末智行与阿里合作,引入了阿里M6大模型,这一大模型已在电商领域经过了海量数据的训练,不仅对人类行为喜好非常了解,还能以此为基础对数据进行可解释性标注。

经过M6大模型预训练得到的算法模型不仅能预测人类驾驶方式,还能对人类司机动作给到一个文字集的解释,算法工程师不仅可以更进一步理解算法决策的逻辑,也能由此对数据进行归类、清洗与筛选,保证数据是干净的,是符合人类正常驾驶习惯与安全的。

以往数据驱动自动驾驶迭代的逻辑就像“填鸭式教育”,只是告诉自动驾驶应该怎么做,而不告诉它为什么这么做,毫末智行则试图弥补了这一缺陷,不仅要告诉自动驾驶算法为什么,还要让其自己讲出为什么,这一解法虽然使用时间不长,但对未来自动驾驶发展会带来极大的影响。

任重道远,自动驾驶的“自证”之路

基于深度神经网络的自动驾驶“黑箱”是客观存在的,现阶段人类虽然能够利用深度神经网络来完成一些智能活动,但想要完全能够“自证”自己的逻辑,还需要人类长期的探索。毕竟人类连自己的神经网络也存在“黑箱”,还有众多未解之谜需要去破解。

想要提升自动驾驶算法的可解释性,要从数据标注与算法模型训练做起,保证决策全程尽可能具备更高的可解释性,由此让“黑箱”逐渐变成“灰箱”、再逐渐变成透明,也能逐渐提升自动驾驶泛化性,能够减少更多corner case出现的可能。

自动驾驶系统只有见多识广,才有可能变得成熟稳重,而自动驾驶只有能给出符合人类理解范围的逻辑和决策,才能被人类真正所信任。因此,自动驾驶的普及,既是一个技术问题,也是一个伦理问题和社会心理问题。自动驾驶算法的可解释性就是打开自动驾驶大众化应用的一道关键之门。开启这道门的尝试,还需要行业玩家们不断尝试。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

文章投诉热线:156 0057 2229 投诉邮箱:29132 36@qq.com